Das Common Security Advisory Framework (CSAF) reguliert die Bereitstellung von maschinenlesbaren Sicherheitshinweisen nach einem standardisierten Prozess, damit sie automatisiert ausgetauscht werden können. Greenbone arbeitet kontinuierlich an der Integration von Technologien, die den CSAF 2.0-Standard für die automatisierte Bereitstellung von Cybersecurity-Informationen nutzen. Eine Einführung in CSAF 2.0 und wie es das Schwachstellenmanagement der nächsten Generation unterstützt, finden Sie in einem früheren Blogbeitrag.

Zu Beginn des Jahres 2024 hat der Ausfall der NIST National Vulnerabilities Database (NVD) den Fluss kritischer Cybersicherheitsinformationen an nachgeschaltete Verbraucher unterbrochen. Dies macht das dezentralisierte CSAF 2.0-Modell zunehmend wichtiger für Cybersicherheitsinformationen, um die Widerstandsfähigkeit gegenüber einem einzelnen Ausfallpunkt zu erhöhen. Wer CSAF 2.0 einführt, kommt einem zuverlässigeren Ökosystem für Cybersicherheitsinformationen einen Schritt näher.

Inhaltsverzeichnis

1. Zusammenfassung

2. Wer sind die CSAF-Stakeholder?

2.1. Rollen im CSAF 2.0-Prozess

2.1.1. CSAF 2.0 Ausstellende Parteien

2.1.1.1. Die Rolle des CSAF-Publishers

2.1.1.2. Die Rolle des CSAF-Providers

2.1.1.3. Die Rolle des Trusted Providers in CSAF

2.1.2. CSAF 2.0 Datenaggregatoren

2.1.2.1. Die Rolle des CSAF-Listers

2.1.2.2. Die Rolle des CSAF-Aggregators

3. Fazit

1. Zusammenfassung

Dieser Artikel stellt die verschiedenen Akteure und Rollen dar, die in der CSAF-2.0-Spezifikation definiert sind. Die Rollen regeln die Mechanismen zur Erstellung, Verbreitung und Nutzung von Sicherheitshinweisen innerhalb des CSAF-2.0-Ökosystems. Das Verständnis, wer die Stakeholder von CSAF sind und welche standardisierten Rollen das CSAF 2.0-Framework definiert, hilft Security-Verantwortlichen klarer zu sehen, wie CSAF funktioniert, ob es für ihre Organisation von Nutzen sein kann und wie CSAF 2.0 zu implementieren ist.

2. Wer sind die CSAF-Stakeholder?

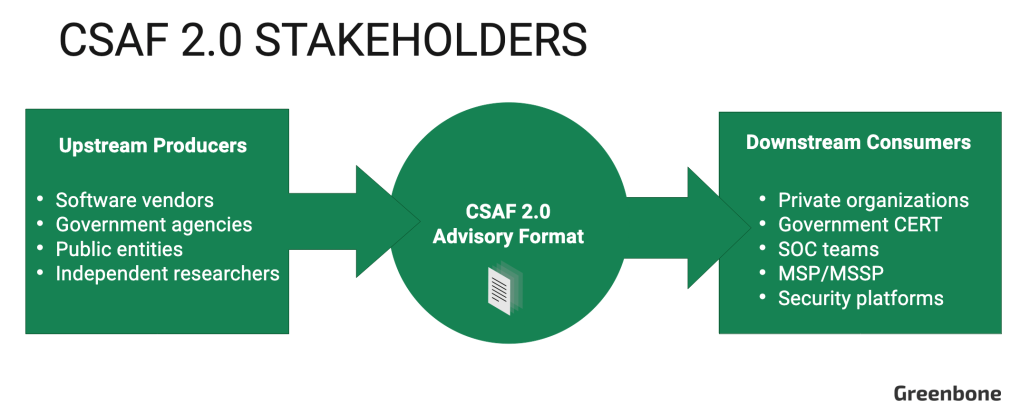

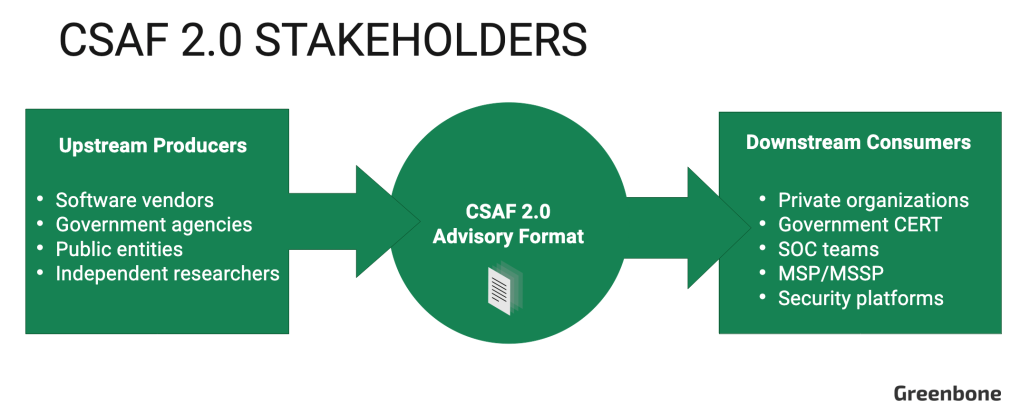

Auf höchster Ebene hat der CSAF-Prozess zwei primäre Stakeholder-Gruppen: vorgelagerte Produzenten, die Cybersicherheitshinweise im CSAF-2.0-Dokumentenformat erstellen und bereitstellen, und nachgelagerte Konsumenten (Endnutzer), die die Hinweise konsumieren und die darin enthaltenen Sicherheitsinformationen anwenden.

Bei den vorgelagerten Herstellern handelt es sich in der Regel um Anbieter von Softwareprodukten (wie Cisco, Red Hat und Oracle), die für die Aufrechterhaltung der Sicherheit ihrer digitalen Produkte und die Bereitstellung öffentlich zugänglicher Informationen über Schwachstellen verantwortlich sind. Zu den vorgelagerten Akteuren gehören auch unabhängige Sicherheitsforscher und öffentliche Einrichtungen, die als Quelle für Cybersicherheitsinformationen dienen, wie die US Cybersecurity Intelligence and Security Agency (CISA) und das deutsche Bundesamt für Sicherheit in der Informationstechnik (BSI).

Zu den nachgelagerten Verbrauchern gehören private Instanzen, die ihre eigene Cybersicherheit verwalten, staatliche CERT-Agenturen, die mit dem Schutz der nationalen IT-Infrastruktur betraut sind, und Managed Security Service Provider (MSSP), die die Cybersicherheit von Kunden überwachen und managen. Die in den CSAF 2.0-Dokumenten enthaltenen Informationen werden von IT-Sicherheitsteams genutzt, um Schwachstellen in ihrer Infrastruktur zu identifizieren und Abhilfemaßnahmen zu planen, und von Führungskräften, um zu beurteilen, wie IT-Risiken den Betrieb beeinträchtigen.

Der CSAF-2.0-Standard definiert spezifische Rollen für vorgelagerte Hersteller, die ihre Beteiligung an der Erstellung und Verbreitung von Hinweis-Dokumenten beschreiben. Diese offiziell definierten Rollen sehen wie folgt aus:

2.1. Rollen im CSAF 2.0-Prozess

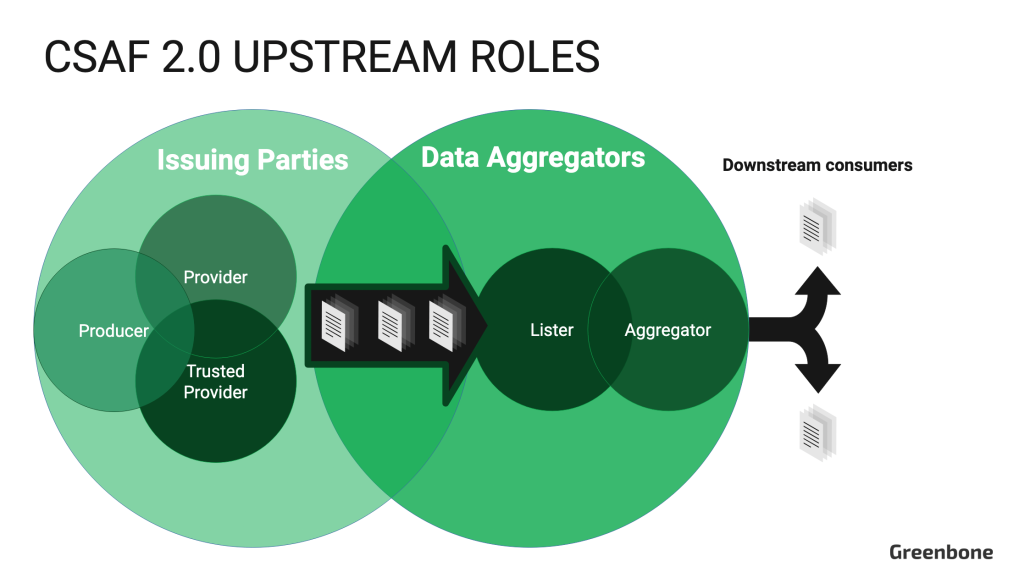

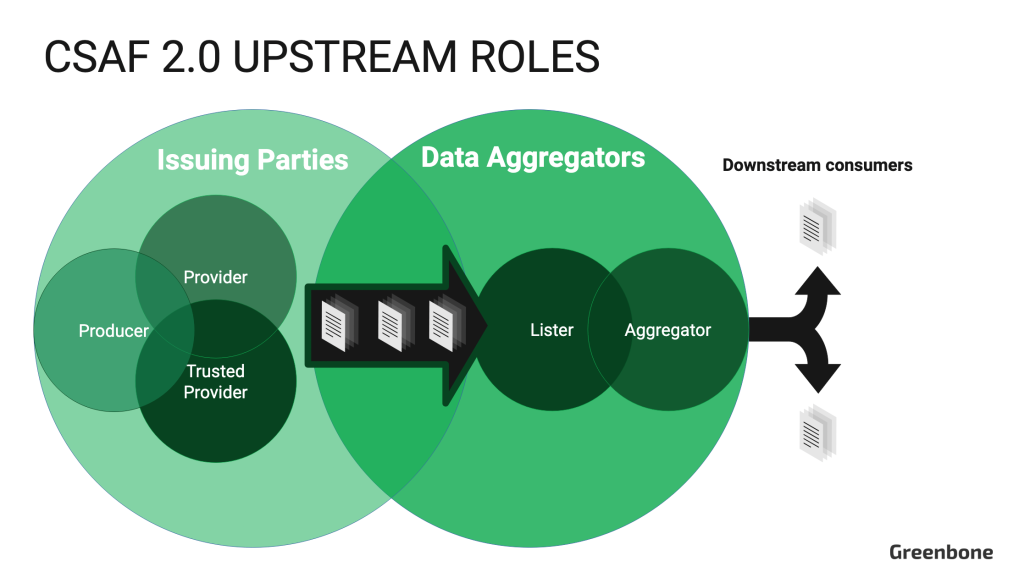

CSAF 2.0-Rollen werden in Abschnitt 7.2 definiert. Sie werden in zwei verschiedene Gruppen unterteilt: Ausstellende Parteien („Issuer“) und Datenaggregatoren („Aggregatoren“). Erstere sind direkt an der Erstellung von Beratungsdokumenten beteiligt. Letztere sammeln diese Dokumente und verteilen sie an die Endnutzer, um die Automatisierung für die Verbraucher zu unterstützen. Eine einzelne Organisation kann sowohl die Rolle des Ausstellers als auch die des Aggregators übernehmen, diese Funktionen sollten jedoch als separate Einheiten betrieben werden. Selbstverständlich müssen Organisationen, die als vorgelagerte Produzenten agieren, auch ihre eigene Cybersicherheit gewährleisten. Daher können sie auch nachgelagerte Verbraucher sein, die CSAF-2.0-Dokumente aufnehmen, um ihre eigenen Aktivitäten im Bereich des Schwachstellenmanagements zu unterstützen.

Die spezifischen Verantwortlichkeiten der CSAF-2.0-Issuer und Datenaggregatoren stellen sich wie folgt dar:

2.1.1. CSAF 2.0 Ausstellende Parteien

Issuers sind die Quelle der CSAF-2.0-Cybersecurity-Hinweise. Sie sind jedoch nicht für die Übermittlung der Dokumente an die Endnutzer verantwortlich. Sie müssen angeben, wenn sie nicht wollen, dass ihre Hinweise von Datenaggregatoren aufgelistet oder gespiegelt werden. Außerdem können CSAF 2.0-Aussteller auch als Datenaggregatoren fungieren.

Hier sind die einzelnen Unterrollen innerhalb der Gruppe der ausstellenden Parteien:

2.1.1.1. Die Rolle des CSAF-Publishers

Publisher sind in der Regel Organisationen, die Hinweise nur im Namen ihrer eigenen digitalen Produkte entdecken und weitergeben. Sie müssen die Anforderungen 1 bis 4 in Abschnitt 7.1 der CSAF 2.0-Spezifikation erfüllen. Dies bedeutet, dass sie strukturierte Dateien mit gültiger Syntax und Inhalten herausgeben, die den in Abschnitt 5.1 beschriebenen CSAF 2.0-Dateinamenskonventionen entsprechen, und sicherstellen, dass die Dateien nur über verschlüsselte TLS-Verbindungen verfügbar sind. Außerdem müssen sie alle als TLP:WHITE klassifizierten Hinweise öffentlich zugänglich machen.

Alle Publisher müssen über ein öffentlich zugängliches provider-metadata.json-Dokument verfügen, das grundlegende Informationen über die Organisation, ihren CSAF-2.0-Rollenstatus und Links zu einem öffentlichen OpenPGP-Schlüssel enthält, mit dem das provider-metadata.json-Dokument digital signiert wird, um seine Integrität zu verifizieren. Diese Informationen werden von Softwareanwendungen verwendet, die die Hinweise der Publisher für Endbenutzer anzeigen.

2.1.1.2. Die Rolle des CSAF-Providers

Provider stellen CSAF-2.0-Dokumente für die breitere Gemeinschaft zur Verfügung. Zusätzlich zur Erfüllung der gleichen Anforderungen wie ein Publisher muss ein Provider seine provider-metadata.json.-Datei nach einer standardisierten Methode bereitstellen (mindestens eine der Anforderungen 8 bis 10 aus Abschnitt 7.1), eine standardisierte Verteilung für seine Hinweise verwenden und technische Kontrollen implementieren, um den Zugang zu allen Hinweisdokumenten mit dem Status TLP:AMBER oder TLP:RED zu beschränken.

Provider müssen außerdem wählen, ob sie die Dokumente auf der Grundlage eines Verzeichnisses oder auf der Grundlage von ROLIE verteilen wollen. Einfach ausgedrückt, stellt die verzeichnisbasierte Verteilung Hinweisdokumente in einer normalen Verzeichnispfadstruktur zur Verfügung, während ROLIE (Resource-Oriented Lightweight Information Exchange) [RFC-8322] ein RESTful-API-Protokoll ist, das speziell für die Automatisierung der Sicherheit, die Veröffentlichung, das Auffinden und die gemeinsame Nutzung von Informationen entwickelt wurde.

Verwendet ein Provider die ROLIE-basierte Verteilung, muss er auch die Anforderungen 15 bis 17 aus Abschnitt 7.1 erfüllen. Verwendet ein Provider die verzeichnisbasierte Verteilung, so muss er alternativ die Anforderungen 11 bis 14 aus Abschnitt 7.1 erfüllen.

2.1.1.3. Die Rolle des Trusted Providers in CSAF

Trusted Provider sind eine besondere Klasse von CSAF-Providern, die sich ein hohes Maß an Vertrauen und Zuverlässigkeit erworben haben. Sie müssen sich an strenge Sicherheits- und Qualitätsstandards halten, um die Integrität der von ihnen ausgestellten CSAF-Dokumente zu gewährleisten.

Zusätzlich zur Erfüllung aller Anforderungen an einen CSAF-Provider müssen Trusted Provider auch die Anforderungen 18 bis 20 aus Abschnitt 7.1 der CSAF 2.0-Spezifikation erfüllen. Diese beinhalten die Bereitstellung eines sicheren kryptographischen Hashs und einer OpenPGP-Signaturdatei für jedes ausgegebene CSAF-Dokument und sie stellen sicher, dass der öffentliche Teil des OpenPGP-Signierschlüssels öffentlich zugänglich gemacht wird.

2.1.2. CSAF 2.0 Datenaggregatoren

Datenaggregatoren konzentrieren sich auf die Sammlung und Weiterverteilung von CSAF-Dokumenten. Sie fungieren als Verzeichnis für CSAF-2.0-Issuers und deren Hinweis-Dokumente sowie als Vermittler zwischen Issuers und Endanwendern. Eine einzelne Instanz kann sowohl als CSAF-Lister als auch als Aggregator fungieren. Datenaggregatoren können je nach den Bedürfnissen ihrer Kunden wählen, welche Hinweis-Dokumente von vorgelagerten Publishern sie auflisten oder sammeln und weiterverteilen.

Hier sind einzelne Unterrollen in der Gruppe der Datenaggregatoren:

2.1.2.1. Die Rolle des CSAF-Listers

Sogenannte „Lister“ sammeln CSAF-Dokumente von mehreren CSAF-Herausgebern und listen sie an einem zentralen Ort auf, um das Auffinden zu erleichtern. Der Zweck eines Listers ist es, als eine Art Verzeichnis für CSAF 2.0-Hinweise zu fungieren, indem URLs konsolidiert werden, unter denen CSAF-Dokumente abgerufen werden können. Es wird nicht davon ausgegangen, dass ein Lister einen vollständigen Satz aller CSAF-Dokumente enthält.

Lister müssen eine gültige aggregator.json-Datei veröffentlichen, die mindestens zwei separate CSAF-Anbieter auflistet. Während ein Lister auch als Issuer fungieren kann, darf er keine gespiegelten Dateien auflisten, die auf eine Domain unter seiner eigenen Kontrolle zeigen.

2.1.2.2. Die Rolle des CSAF-Aggregators

Die Rolle des CSAF-Aggregators stellt den letzten Wegpunkt zwischen den veröffentlichten CSAF-2.0-Hinweis-Dokumenten und dem Endanwender dar. Aggregatoren bieten einen Ort, an dem CSAF-Dokumente durch ein automatisiertes Tool abgerufen werden können. Obwohl Aggregatoren als konsolidierte Quelle für Cybersicherheitshinweise fungieren, vergleichbar mit NIST NVD oder CVE.org der MITRE Corporation, handelt es sich bei CSAF 2.0 um ein dezentralisiertes Modell, im Gegensatz zu einem zentralisierten Modell. Aggregatoren sind nicht verpflichtet, eine umfassende Liste von CSAF-Dokumenten von allen Herausgebern anzubieten. Außerdem können die Herausgeber ihren CSAF-Beratungsfeed kostenlos zur Verfügung stellen oder als kostenpflichtigen Dienst betreiben.

Ähnlich wie Lister müssen Aggregatoren eine aggregator.json-Datei öffentlich zugänglich machen, und CSAF-Dokumente von jedem gespiegelten Issuer müssen in einem separaten Ordner zusammen mit der provider-metadata.json des Issuers abgelegt werden. Im Wesentlichen müssen Aggregatoren die Anforderungen 1 bis 6 und 21 bis 23 aus Abschnitt 7.1 der CSAF-2.0-Spezifikation erfüllen.

CSAF-Aggregatoren sind auch dafür verantwortlich, sicherzustellen, dass jedes gespiegelte CSAF-Dokument eine gültige Signatur (Anforderung 19) und einen sicheren kryptografischen Hash (Anforderung 18) besitzt. Wenn die ausstellende Partei diese Dateien nicht zur Verfügung stellt, muss der Aggregator sie erzeugen.

3. Fazit

Das Verständnis der CSAF 2.0-Stakeholder und -Rollen ist entscheidend für die ordnungsgemäße Umsetzung von CSAF 2.0 und die Nutzung der automatisierten Erfassung und Nutzung wichtiger Cybersicherheitsinformationen. Die CSAF 2.0-Spezifikation definiert zwei Hauptinteressengruppen: vorgelagerte Produzenten, die für die Erstellung von Cybersicherheitshinweisen verantwortlich sind, und nachgelagerte Verbraucher, die diese Informationen zur Verbesserung der Sicherheit nutzen. Zu den Rollen innerhalb von CSAF 2.0 gehören Issuer (Herausgeber, Anbieter und vertrauenswürdige Anbieter), die Hinweise erstellen und verteilen, und Datenaggregatoren wie Lister und Aggregatoren, die diese Hinweise sammeln und an die Endnutzer weitergeben.

Die Mitglieder jeder Rolle müssen sich an bestimmte Sicherheitskontrollen halten, die die sichere Übertragung von CSAF 2.0-Dokumenten unterstützen. Das Traffic Light Protocol (TLP) regelt, wie Dokumente freigegeben werden dürfen und welche Zugriffskontrollen erforderlich sind.