Auch im 16. Jahr seines Bestehens hat der Osnabrücker Experte und Marktführer im Open Source Vulnerability Management kräftig zugelegt: sowohl an Mitarbeitern, Kunden, Partnern und nicht zuletzt in diesem Blog.

Greenbone wächst weiter: In den letzten beiden Jahren konnten wir unsere Belegschaft fast verdoppeln, auf jetzt 143 Mitarbeiter, die meisten davon arbeiten remote. Natürlich brachte dieses Wachstum viel neuen, positiven Input mit sich, auch in diesem Blog, aber auch neue Strukturen – und Partys. Einen großen Schritt in der Weiterentwicklung unserer Führungskultur stellten dabei das neue People-Lead-Konzept, die „Development Talks“ mit „Cross Feedback“ und die Happiness-Erhebungen dar. Das gewachsene, weltweit verteilte Team traf sich auf diversen Veranstaltungen und besuchte zahlreiche Events zusammen. Greenbone wird weiterwachsen und ist ein moderner und beliebter Arbeitgeber. Haben Sie sich schon beworben?

Greenbone Threat Report

Es ist also kein Wunder, dass auch dieser Blog vom Wachstum profitiert und ein erfolgreiches neues Format eingeführt hat: Jeden Monat präsentiert Greenbone hier den Threat Report einen monatlichen Deep Dive in die Neuigkeiten und Schrecken des Schwachstellenmanagements, der Schadensbegrenzung und neuer Bedrohungen, die unserer Kunden (und alle, die sich für Sicherheit interessieren) auf dem Radar haben sollten. Die Serie begann im März 2024 und hat bisher zehn detaillierte Blogbeiträge hervorgebracht. Das letzte Update liegt hier.

Vom Aussterben bedroht: Ivanti, Fortinet, Exchange, Confluence…

Darüber hinaus konnten wir über mehrere kritische Schwachstellen berichten. Von Juniper und Ivanti bis Fortinet, von Problemen in Microsoft Exchange und Sharepoint bis zu Atlassians Wissensmanagement Confluence lieferten unsere Experten hilfreiche Einblicke für unsere Kunden.

Natürlich haben wir in unserem Blog über CrowdStrike berichtet und darüber, wie ein Sicherheitsanbieter in nur 62 Minuten zu einer massiven Bedrohung werden konnte. Wir informierten über die nicht enden wollenden Gefahren durch chinesische Hacker, DOS-Angriffe, automatisierte Massenangriffe und schwerwiegende SSH-Key-Probleme und brachten ausführliche Analysen und Beiträge, zum Beispiel zu den Kosten von Cyberangriffen.

Wachsende Herausforderungen: Cyberbedrohungen und neue Gesetze

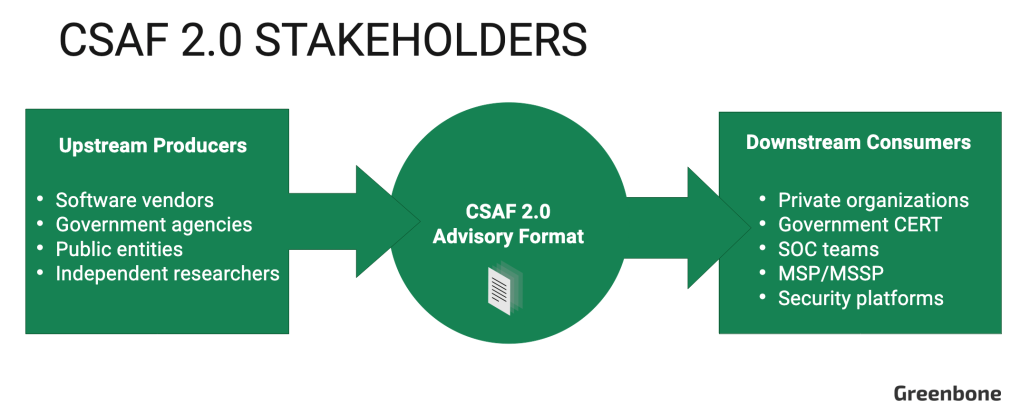

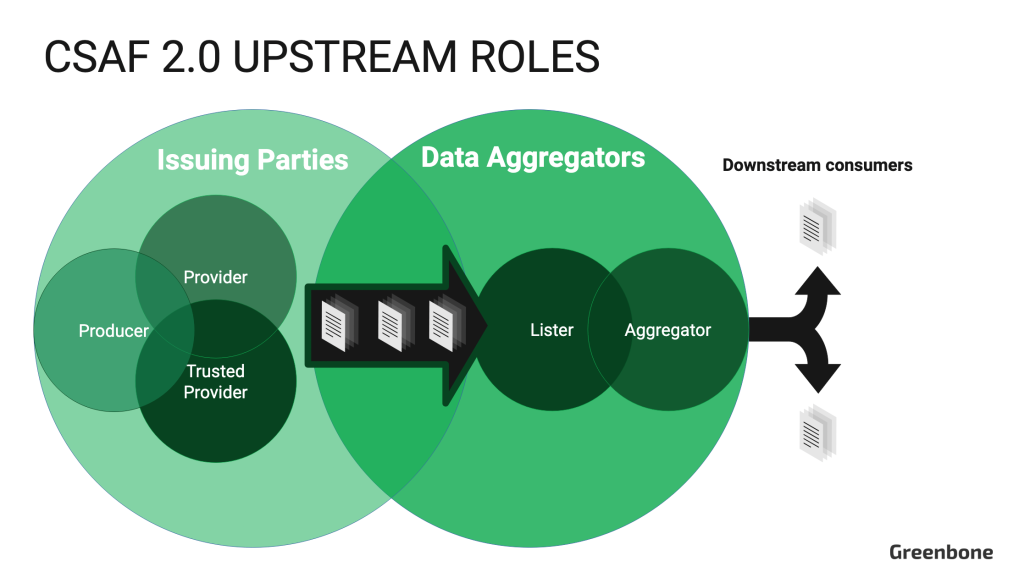

In fünf Blogbeiträgen haben wir die Bedrohungslage und die spezifischen Sicherheitsrisiken in Branchen erläutert, die 2024 von Sicherheitslücken besonders stark betroffen waren: Der Mittelstand investiert mehr in Sicherheit, Schulen in Helsinki wurden angegriffen, und natürlich sind die Netze der öffentlichen Verwaltung besonders bedroht, ebenso wie praktisch alles im Gesundheitswesen, sagt das BSI (Bundesamt für Sicherheit in der Informationstechnik). Vor allem die beiden letztgenannten Branchen, nicht nur unter unseren Kunden, werden auch von den vielen Beiträgen profitiert haben, die wir zu Regulierungen veröffentlicht haben, etwa zu CSAF (Common Security Advisory Framework) und, mit vielen Updates, zum langsamen und (in Deutschland) unterbrochenen Fortschritt von NIS2 (Network and Information Security).

Ganzjahresthema NIS2

Die NIS-Richtlinie in ihrer zweiten Auflage war und ist ein Thema, das Greenbone und unsere Kunden immer wieder beschäftigt hat. Seit die Europäische Union die zweite „Richtlinie über die Sicherheit von Netz- und Informationssystemen“ NIS beschlossen hat, haben viele Mitgliedsstaaten Regelungen erlassen, die klarstellen, wie Unternehmen die Richtlinie umsetzen müssen. Nur in Deutschland hat das etwas länger gedauert und ist – bedingt durch den Sturz der Regierung Ende des Jahres – noch nicht abgeschlossen. Nichtsdestotrotz sind alle Informationen und Pläne verfügbar, es gibt sogar einen Test des BSI, mit dem Sie überprüfen können, ob Ihre Netzwerke betroffen sind und sofortige Maßnahmen erforderlich sind.

Greenbone in Grün: ISO 14001

Einen großen Erfolg konnte Greenbone 2024 mit der ISO 14001, einer Zertifizierung für Nachhaltigkeit erzielen. Unser CMO Elmar Geese teilte seine Gedanken über die Zukunft der Clouds und das Aufbrechen ihres Hype-Zyklus. Außerdem nahm er an einem Panel zum Thema Künstliche Intelligenz teil, was die Greenbone-Produkte neuerdings auch integrieren, ebenso wie die BSI-Grundschutz- und CIS-Richtlinien zum Schutz Ihrer Office-Software.

Neue Produkte: Major Release 24.10, Greenbone Basic, Feed-Updates

Aber 2024 bescherte auch viele Aktualisierungen und Neuigkeiten zu den Produkten: Das Schwachstellenmanagement von Greenbone erhielt mehrere Verbesserungen und Updates, mit einem neuen Video, das Schwachstellenmanagement in 11 Minuten erklärt. Im Juli erhielt unsere neue Scan-Engine Notus Unterstützung für Amazons Red-Hat-Linux-Variante, die Amazon Web Services dominiert. Später im Jahr 2024 kündigte Greenbone sowohl eine neue Major Version der Enterprise Appliance (24.10) als auch ein völlig neues Produkt an, das sich an kleine und mittlere Unternehmen richtet und „Greenbone Basic“ heißt. Bereit zum Ausprobieren?

Vielleicht möchten Sie aber auch lesen, wie Greenbone die Konkurrenz der Schwachstellen-Scanner in unserem Benchmark anführt oder herausfinden, was Ihre Key Performance Indicators für die Messung der Leistung Ihres Schwachstellen-Management-Produktes sind?

Kongresse und Events: Unsere Highlights des Jahres

Wenn Sie uns treffen wollen, finden Sie eine wachsende Anzahl von Gelegenheiten… weltweit, wie auch in unserem Blog gezeigt: Wir berichteten fast live von der anderen Seite des Globus, wo Greenbone auf der Singapore International Cyber Week vertreten war. Diese Konferenz war nicht nur eine der wichtigsten IT-Sicherheitsveranstaltungen in Asien, sondern auch eine in einer langen Liste von Geschäfts-Messen, an denen Greenbone teilnahm: Die Public IT Security (PITS) in Berlin, die it-sa in Nürnberg oder die Potsdamer Konferenz für Nationale Sicherheit, um nur einige zu nennen.

Vielen Dank und frohe Festtage!

Natürlich war auch unser 16. Jahr ein gutes Jahr, „ein sehr gutes Jahr“, und so möchten wir die Gelegenheit nutzen, um uns noch einmal bei allen Kunden, Partnern und der Community zu bedanken, denn ohne Ihre Hilfe wäre das alles nicht möglich gewesen.

Vielen Dank, frohe Festtage und ein gutes neues Jahr!